En esta práctica estudiamos dos tipos de problemas. El primero es el de encontrar una función que se ajuste lo mejor posible a un conjunto de puntos observados, gráficamente equivale a encontrar una curva que aunque no pase por todos los puntos esté lo más próxima posible de dichos puntos. El segundo es medir el grado de ajuste entre la función teórica (función ajustada) y la nube de puntos. Distinguimos así, entre Teoría de Regresión y Teoría de Correlación.

En primer lugar se plantea el ajuste de una recta entre dos variables. Sea Y la variable dependiente (variable cuyos valores se desea predecir), y X la variable independiente (también llamada variable explicativa y que se utiliza para predecir el valor de la variable dependiente).

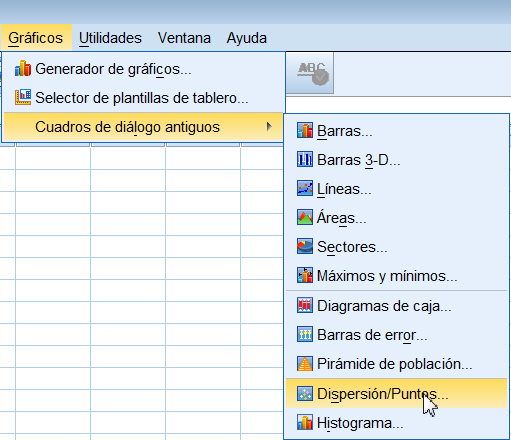

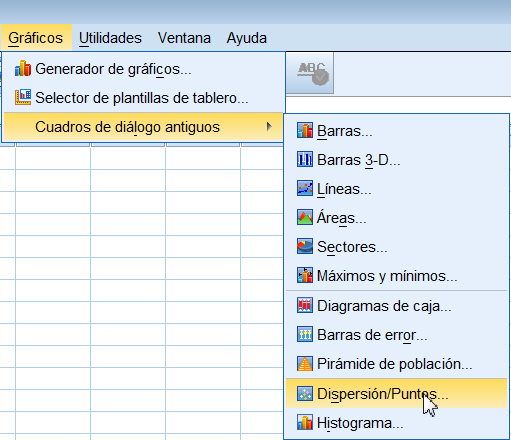

se muestra la siguiente ventana

Se selecciona la opción que se desee representar, que en nuestro caso es Dispersión simple y se pulsa el botón Definir. En la ventana correspondiente se sitúan las variables X e Y en su lugar correspondiente.

Se pulsa Aceptar y se muestra el gráfico de dispersión

El gráfico muestra una posible adecuación del modelo lineal y la tendencia creciente del mismo.

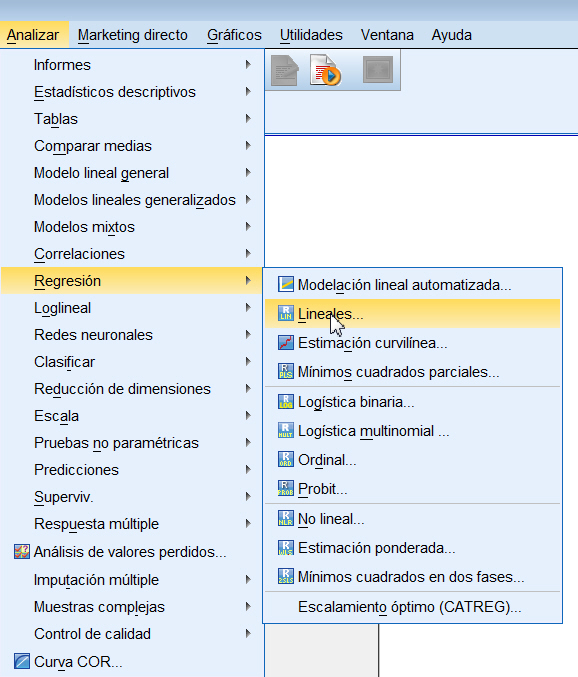

Para obtener la recta de regresión mínima cuadrática de Y sobre X , y = b0 + b1 x, se debe elegir el procedimiento Regresión lineal. Para ello se selecciona Analizar/Regresión/Lineales...

Se muestra la siguiente ventana

Se desplazan las variables X e Y a su campo correspondiente

Se pulsa el botón Estadísticos...

donde se selecciona en Coeficientes de regresión: Estimaciones e Intervalos de confianza y se marca Ajuste del modelo. Se pulsa Continuar.

Se pulsa el botón Gráficos...

donde se elige *ZRESID para Y y *ZPRED para X. Por último se marca la opción Gráfico de prob. normal. Se pulsa Continuar

Las representaciones gráficas son una forma de juzgar visualmente la bondad de ajuste y de detectar comportamientos extraños de observaciones individuales, valores atípicos. Una visión global de la gráfica nos puede orientar sobre el cumplimiento de los supuestos del modelo: Normalidad, Linealidad y Homocedasticidad (Igualdad de las Varianzas) e Independencia de los Residuos. Además de representar un Histograma y un Gráfico Probabilístico Normal, también se pueden confeccionar diversos gráficos que aportan información sobre el cumplimiento de las hipótesis del modelo. Así se pueden realizar Diagramas de Dispersión para cualquier combinación de las siguientes variables: la variable dependiente, los valores pronosticados (ajustados o predichos), residuos tipificados (estandarizados), los residuos eliminados (sin considerar el caso), ajustados en función de los valores pronosticados, residuos estudentizados, o residuos estudentizados eliminados (sin considerar el caso).

Por ejemplo:

Gráfico de Residuos tipificados/Valores pronosticados tipificados o simplemente Residuos/Valor predicho: Este gráfico se utiliza para comprobar las hipótesis de Linealidad y de Homocedasticidad y estudiar si el modelo es adecuado o no. Si en el gráfico observamos alguna tendencia, ésta puede ser indicio de autocorrelación, de heterocedasticidad o falta de linealidad. En general no se debe observar ninguna tendencia ni comportamiento anómalo.

Gráfico de Valores Observados/Valores predichos: Este gráfico incluye una línea de pendiente 1. Si los puntos están sobre la línea indican que todas las predicciones son perfectas. Como el gráfico anterior, también se utiliza para comprobar la hipótesis de igualdad de varianzas, así se detecta los casos en que la varianza no es constante y se determina si es preciso efectuar una transformación de los datos que garantice la homocedasticidad.

Gráfico de Residuos/Variable X: Este gráfico que representa los residuos frente a una variable independiente, permite detectar la adecuación del modelo con respecto a la variable independiente seleccionada y también detecta si la varianza de los residuos es constante en relación a la variable independiente seleccionada. Si en este gráfico observamos alguna tendencia nos puede indicar el incumplimiento de la hipótesis de homocedasticidad o falta de linealidad, así como autocorrelación.

Se pulsa el botón Guardar...

y en Valores pronosticados y Residuos se elige Tipificados. Se pulsa Continuar. En la ventana del Editor de datos se han creado dos variables con los nombres ZPR_1 (para los valores pronosticados tipificados) y ZRE_1 (para los residuos tipificados).

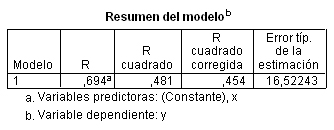

Se pulsa Continuar y Aceptar. Y se obtienen, entre otros, los siguientes resultados

Esta tabla muestra los resultados del ajuste del modelo de regresión. El valor de R cuadrado, que corresponde al coeficiente de determinación, mide la bondad del ajuste de la recta de regresión a la nube de puntos, el rango de valores es de 0 a 1. Valores pequeños de R cuadrado indican que el modelo no se ajusta bien a los datos. R cuadrado = 0.481 indica que el 48.1% de la variabilidad de Y es explicada por la relación lineal con X. El valor R (0.694) representa el valor absoluto del Coeficiente de Correlación, es decir es un valor entre 0 y 1. Valores próximos a 1 indican una fuerte relación entre las variables. La última columna nos muestra el Error típico de la estimación (raíz cuadrada de la varianza residual) con un valor igual a 16.52243

En la Tabla ANOVA, se muestra la descomposición de la Variabilidad Total (SCT = 10000) en la Variabilidad debida a la Regresión (SCR_{reg = 4813.175) y la Variabilidad Residual (SCR = 5186.825) es decir en Variabilidad explicada por el modelo de regresión y la Variabilidad no explicada. SCT = SCR_{eg} + SCR. La Tabla de Ánalisis de la Varianza (Tabla ANOVA) se construye a partir de esta descomposición y proporciona el valor del estadístico F que permite contrastar la hipótesis nula de que la pendiente de la recta de regresión es igual a cero contra la alternativa de que la pendiente es distinta de cero, es decir:

donde H0 se conoce, en general, como hipótesis de no linealidad entre X e Y

La Tabla ANOVA muestra el valor del estadístico de contraste, F = 17.631, que se define como el cociente entre el Cuadrado medio debido a la regresión (CMR_{eg} = 4813.175) y el Cuadrado medio residual (CMR = 272.991), por tanto cuanto mayor sea su valor, mejor será la predicción mediante el modelo lineal. El p-valor asociado a F, en la columna Sig, es menor que 0.001, menor que el nivel de significación α = 0.05, lo que conduce a rechazar la hipótesis nula, es decir existe una relación lineal significativa entre Y y X. Esto indica que es válido el modelo de regresión considerado, en este caso el modelo lineal simple. Sin embargo, esto no significa que este modelo sea el único válido, puesto que pueden existir otros modelos también válidos para predecir la variable dependiente.

La siguiente tabla muestra las estimaciones de los parámetros del modelo de regresión lineal simple, la ordenada en el origen, ß0=375.252 y la pendiente ß1= 0.036

Por tanto, la ecuación de la recta estimada o ajustada es: y =375.252 + 0.036 x. Así mismo, en esta tabla se presentan los resultados de los dos contrastes individuales de la significación de cada uno de estos parámetros

El análisis de normalidad de los residuos lo realizaremos gráficamente

(Histograma y gráfico de probabilidad normal) y analiticamente (Contraste

de Kolmogorov-Smirnov)

Histograma

Representaremos los residuos mediante un histograma superponiendo sobre

él una curva normal de media cero. Si los residuos siguen un distribución

normal las barras del histograma deberán representar un aspecto similar

al de dicha curva.

En primer lugar se guardan los residuos tipificados (realizado anteriormente),

para ello en el Cuadro de diálogo de Analizar/Regresión/Lineal...

se pulsa el botón Guardar... y en Residuos

elegimos Tipificados. Clik Continuar y

Aceptar.

En la ventana del Editor de datos se ha creado una variable con el nombre ZRE_1.

A continuación representamos el histograma, para ello elegimos Gráfico/Cuadros de diálogo antiguos/Histograma... y en la ventana emergente seleccionamos la variable que representa los residuos tipificados y marcamos la opción Mostrar curva normal

Se pulsa Continuar y Aceptar y se muestra el siguiente histograma con la curva normal superpuesta. Podemos apreciar, en este gráfico, que los datos no se aproximan razonablemente a una curva normal, puede ser consecuencia de que el tamaño muestral considerado es muy pequeño (Esta representación no es aconsejable en tamaños muestrales pequeños).

Gráfico probabilístico normal

Es el procedimiento gráfico más utilizado para comprobar la

normalidad de un conjunto de datos. Para obtener dicho gráfico seleccionamos

Analizar/Estadísticos descriptivos/Gráficos Q-Q...

en el Cuadro de diálogo resultante se selecciona la variable

que representa los residuos tipificados

Se muestra el Gráfico siguiente que representa las funciones de distribución teórica y empírica de los residuos tipificados. En el eje de ordenadas se representa la función teórica bajo el supuesto de normalidad y en el eje de abcisas, la función empírica. Desviaciones de los puntos del gráfico respecto de la diagonal indican alteraciones de la normalidad. Observamos la ubicación de los puntos del gráfico, estos puntos se aproximan razonablemente bien a la diagonal lo que confirma la hipótesis de normalidad.

Contraste de normalidad: Prueba de Kolomogorov-Smirnov

El estudio analítico de la normalidad de los residuos lo realizaremos

mediante el contraste no-paramétrico de Kolmogorov-Smirnov.

Seleccionamos Analizar/Pruebas no paramétricas/Cuadros de diálogos antiguos/K-S de 1 muestra...

en el Cuadro de diálogo resultante se selecciona la variable que representa los residuos tipificados

La salida correspondiente la muestra la siguiente tabla

Esta tabla muestra la mayor diferencia entre los resultados esperados en caso de que los residuos surgieran de una distribución normal y los valores observados. Se distingue entre la mayor diferencia en valor absoluto, la mayor diferencia positiva y la mayor diferencia negativa. Se muestra el valor del estadístico Z (0.861) y el valor del p-valor asociado (0.448). Por lo tanto no se puede rechazar la hipótesis de normalidad de los residuos.

Se pulsa Continuar y Aceptar y se muestra el siguiente gráfico

Si trazamos una línea horizontal a la altura de

0, la variación de los residuos sobre esta línea, si las varianzas

son iguales, debería ser semejante para los diferentes valores de

Y. En el gráfico podemos observar, razonablemente, dicho comportamiento

si exceptuamos algún residuo atípico que está por encima

de 2. No apreciamos tendencia clara en este gráfico, los residuos

no presentan estructura definida respecto de los valores predichos por el

modelo por lo que no debemos rechazar la hipótesis de homocedasticidad.

Este mismo gráfico resulta muy útil para detectar indicios

de falta de adecuación del modelo propuesto a los datos, posibles

desviaciones de la hipótesis de linealidad. Si observamos trayectorias

de comportamiento no aleatorio esto es indicio de que el modelo propuesto

no describe adecuadamente los datos.

SPSS proporciona el valor del estadístico de Durbin-Watson

pero no muestra el p-valor asociado por lo que hay que utilizar las tablas

correspondientes. El estadístico de Durbin-Watson mide el

grado de autocorrelación entre el residuo correspondiente a cada

observación y la anterior. Si su valor está próximo

a 2, entonces los residuos están incorrelados, si se aproxima a 4,

estarán negativamente autocorrelados y si su valor está cercano

a 0 estarán positivamente autocorrelados. En nuestro caso, toma el

valor 1.747, próximo a 2 lo que indica la incorrelación

de los residuos.

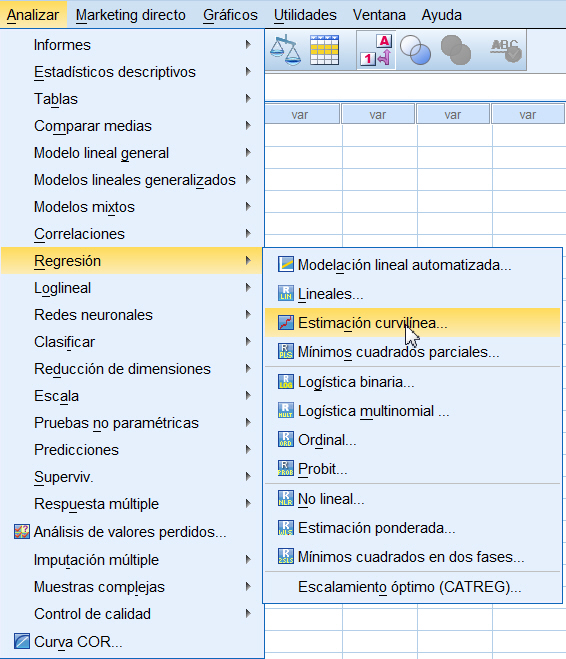

El Diagrama de dispersión y el valor de R cuadrado (0.481),

nos muestra que el ajuste lineal no es satisfactorio por lo que se deben

considerar otros modelos.

se muestra la siguiente ventana

Se sitúan las variables X e Y en su campo correspondiente y se marca en Modelos la opción Cuadrático. Para incluir en el modelo el término constante (b0) se deja marcada la opción de Incluir constante en la ecuación. Si se desea obtener el gráfico de la función ajustada junto con la nube de puntos hay que dejar marcada la opción de Representar los modelos.

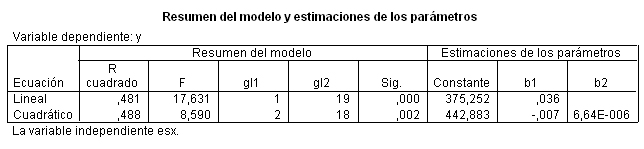

Se pulsa Aceptar y se obtienen las siguientes salidas

El modelo ajustado tiene la siguiente expresión y = 442.883 - 0.007 x + 6.64E-006 x^2.

La representación gráfica de la función ajustada junto con el diagrama de dispersión es:

Se aprecia que la función curvilínea se ajusta

moderadamente al diagrama de dispersión.

Para comparar las gráficas del ajuste lineal y del ajuste parabólico,

se tienen que dejar seleccionados ambos modelos en la ventana de Estimación

curvilínea. Se pulsa Aceptar y se obtienen

los siguientes resultados

La comparación del ajuste de ambos modelos se puede

realizar a partir de los valores del coeficiente de determinación

de cada uno de ellos, en este caso R cuadrado (lineal) = 0.481

y R cuadrado (cuadrático) = 0.488. Los resultados

en el caso lineal son un poco menos satisfactorios que el cuadrático.

Se aprecia, en el gráfico que el modelo cuadrático (línea

discontinua) se aproxima un poco mejor a la nube de puntos que el modelo

lineal (línea continua).

También podemos realizar la comparación del ajuste de los dos modelos a partir de las varianzas residuales. Para ello se debe marcar en la ventana de Estimación curvilínea la opción Mostrar tabla de ANOVA

Y se muestran los siguientes resultados

Para el modelo lineal

Para el modelo cuadrático

Los resultados en el caso lineal son un poco menos satisfactorios.

En la Tabla ANOVA se muestra un p-valor = 0.002 menor que el nivel de significación α = 0.05, por lo que se rechaza la hipótesis nula de no regresión curvilínea. Conviene puntualizar que la elección de un modelo de regresión debe tener en cuenta no sólo la bondad del ajuste numérico sino también la adecuación gráfica de los datos al mismo y, finalmente, su adecuación o explicación biológica.